فهرست عناوین

فایل robots.txt که به آن نقشه راه رباتها هم میگویند، حکم یک تابلوی راهنما را برای موتورهای جستجو دارد. در دنیای وب رباتهای موتور جستجو بیوقفه در حال گشتوگذار در تار و پود صفحات وب هستند تا اطلاعات را گردآوری و در فهرست خود ذخیره کنند. اما در این میان، شما به عنوان صاحب وبسایت این اختیار را دارید که تعیین کنید ربات های موتور جستجو کدام بخشها را میتوانند ببینند و کدامیک را باید از نظر دور نگه دارند. دقیقا اینجاست که باید بدانید فایل robots.txt چیست و چگونه می تواند به کمک شما بیاید.

اگر در حال آموزش سئو هستید و قصد دارید این تخصص را به طور حرفه ای یاد بگیرید، لازم است به خوبی نحوه استفاده از فایل robots.txt را بلد باشید. ما در این مقاله از وبلاگ سئو یوز وب قصد داریم در مورد کاربرد و آموزش ساخت فایل robots.txt سایت، نحوهی عملکرد آن، دستورات مهم و نکات کلیدی برای تنظیم و بهینه سازی صحیح این فایل صحبت کنیم. پس تا انتهای این مطلب جذاب و کاربردی با ما همراه باشید تا تسلط خود را بر دنیای سئو به سطحی بالاتر ارتقاء دهید!

فایل robots.txt چیست؟

فایل robots.txt مجموعه ای از دستورالعمل ها برای ربات ها است که به آنها میگوید به کدام صفحات وب میتوانند یا نمیتوانند دسترسی داشته باشند. این فایل در اکثر وب سایت ها وجود دارد و بیشتر برای مدیریت فعالیت رباتها مانند خزندههای گوگل در نظر گرفته شدهاند.

بیایید با ذکر یک مثال توضیح دهیم. فایل robots را درست مانند علامت های اختصاری که برای رعایت قوانین یک باشگاه ورزشی یا مکان های عمومی بر روی دیوارها نصب شده است تصور کنید. این علامت ها به خودی خود قدرتی برای اجرای قوانین ذکر شده ندارند، اما معمولا اکثر افراد با دیدن آنها این قوانین را رعایت خواهند کرد، در حالی که ممکن است بعضی دیگر احتمالا آنها را زیر پا گذاشته و توجهی به این قوانین نداشته باشند.

ربات یک برنامه کامپیوتری خودکار است که با وب سایت ها و برنامه های مختلف تعامل دارد. در این بین ما هم ربات های خوب داریم و هم ربات بد! به طور مثال یک نوع ربات خوب، ربات خزنده وب نامیده می شود. این رباتها صفحات وب را خزش (Crawl) کرده و محتوا را فهرستبندی (Index) میکنند تا بتواند در نتایج موتورهای جستجو نمایش داده شوند.

یک نمونه فایل robots.txt

User-agent: *

Allow: /

Allow: /index.php

Allow: /category/

Disallow: /wp-admin/

Disallow: /wp-includes/

Sitemap: https://example.com/sitemap.xml

در این فایل نمونه:

- به همه خزندهها اجازه داده میشود به تمام صفحات و پوشههای وبسایت به جز پوشههای wp-admin و wp-includes دسترسی داشته باشند.

- صفحه اصلی (index.php) و دستهبندیها (category/) به طور خاص مجاز هستند.

- URL نقشه سایت نیز به خزندهها معرفی شده است.

فایل robots.txt کجاست؟

حال که با این فایل مهم آشنا شدید، شاید از خودتان سوال کنید محل فایل robots.txt کجاست و چطور باید آن را پیدا کنم تا امکان مدیریت یا ویرایش آن را داشته باشم؟ ما در ادامه به طور کامل شما را در این زمینه راهنمایی خواهیم کرد.

محل فایل robots.txt سایت (Front-end)

خزنده های گوگل همیشه فایل robots را در ریشه وب سایت شما جستجو می کنند، به عنوان مثال آدرس آن چیزی شبیه لینک زیر خواهد بود:

https://www.YourSite.com/robots.txt

در واقع کافیست آدرس دامنه خود را به طور کامل در مرورگر وارد کرده و سپس فقط “robots.txt/” را به انتهای آن اضافه کنید. اگر چیزی بالا نیامد، وب سایت شما هنوز فایل robots ندارد. اما نگران نباشید، ما در ادامه این مقاله آموزش نحوه ساخت فایل robots.txt را هم به شما توضیح خواهیم داد.

محل فایل robots.txt سمت سرور (Back-end)

اگر از یک سیستم مدیریت محتوا (CMS) مانند وردپرس، پرستاشاپ یا مجنتو استفاده می کنید، می توانید این فایل را در درون این CMSها به راحتی پیدا کرده و مدیریت کنید. در ادامه در این زمینه بیشتر به شما توضیح خواهیم داد.

فایل robots.txt در وردپرس (WordPress)

در وردپرس به طور پیش فرض، فایل robotsدر همان مسیری که فایل های اصلی آن مانند wp-config.php قرار دارند، پیدا می شود. با این حال روش های متعددی وجود دارد تا بتوانید این فایل را در وردپرس پیدا کنید:

- می توانید با استفاده از یک ابزار FTP یا File Manager در هاست خود به این پوشه دسترسی پیدا کنید. نام فایل robots.txt است و با یک پسوند متنی (txt.) نمایش داده می شود. با یک جستجوی ساده در کنترل پنل سی پنل (Cpanel) یا دایرکت ادمین (DirectAdmin) هاست خود می توانید این فایل را به راحتی پیدا کنید.

- روش دوم استفاده از افزونه های وردپرس است. افزونه های متعددی برای وردپرس وجود دارند که به شما امکان می دهند فایل robots را ویرایش و مدیریت کنید. برخی از این افزونه های محبوب: افزونه رنک مث (RankMath)، افزونه یواست (Yoast) و افزونه All in One SEO Pack هستندکه به شما امکان ویرایش فایل robots را می دهند.

- در نهایت روش سوم استفاده از ابزارهای آنلاین است. چندین ابزار آنلاین وجود دارند که به شما امکان می دهند فایل robots وب سایت خود را مشاهده، تست یا ایجاد کنید. به عنوان مثال: technicalseo.com یا smallseotools.com از این دست هستند.

فایل robots.txt در پرستاشاپ (Perstashop)

در پرستاشاپ هم همانند وردپرس، فایل robots.txt به طور پیش فرض در ریشه وبسایت شما، در همان مسیری که فایلهای اصلی وبسایت مانند index.php قرار دارند، پیدا میشود. میتوانید با استفاده از یک ابزار FTP یا فایل منیجر هاست خود به این فایل دسترسی پیدا کنید. مسیر دقیق فایل robots در پرستاشاپ به شرح زیر است:

public_html/robots.txt

همچنین امکان استفاده از پنل مدیریت پرستاشاپ نیز وجود دارد. برخی از ماژولهای سئو در پرستاشاپ وجود دارند که به شما امکان میدهند فایل robots را از طریق پنل مدیریت ویرایش کنید. برای استفاده از این روش، باید ماژول سئو را نصب و فعال کرده باشید.

فایل robots.txt در مجنتو (Magento)

فایل robots.txt در ریشه اصلی وب سایت مجنتو شما قرار دارد. به طور دقیق تر، می توانید آن را در مسیر public_html/robots.txt پیدا کنید. همچنین از طریق پنل کاربری مجنتو می توانید به این فایل دسترسی پیدا کنید. برای این منظور به به پنل مدیریت مجنتو خود وارد شوید. سپس به مسیر Stores > Settings > Configuration > General > SEO بروید و در بخش File Robots.txt می توانید محتوای این فایل را مشاهده و ویرایش کنید.

محتوای فایل robots.txt شامل چه چیزهایی است؟

همانطور که قبلا هم توضیح دادیم، این فایل به رباتهای موتورهای جستجو مانند گوگل میگوید که به کدام بخشهای سایت شما اجازه ورود دارند و به کدام بخشها نه. به عنوان مثال صفحاتی که حاوی اطلاعات حساسی مانند پنل مدیریت (مثل /wp-admin/) یا نسخه وردپرس شما (مثل /readme.html/) هستند را می توانید پنهان کنید. یا پوشههایی که برای رباتها بیفایده هستند، مانند پوشه افزونهها (/plugins/) را مخفی کنید.

علاوه بر این لیست ممنوعه، میتوانید به رباتها آدرس نقشه سایت خود را هم بدهید تا راحتتر در سایت شما بچرخند و همه صفحات را پیدا کنند. این مواردی که گفتیم فقط ملاحظات اولیه هستند. شما میتوانید هر صفحهای را که میخواهید در لیست ممنوعه قرار دهید یا این که دسترسی به صفحات ضروری را آزاد کنید. تصمیم با شماست!

آموزش ساخت فایل robots.txt به 3 روش مختلف

به طور کلی شما به 3 روش مختلف می توانید نسبت به ساخت فایل robots.txt اقدام کنید:

روش دستی

- انتخاب ویرایشگر: برای ساخت فایل robots.txt میتوانید از هر ویرایشگر متنی ساده مانند ++Notepad یا Sublime Text استفاده کنید.

- ایجاد فایل: به ریشه دایرکتوری وبسایت خود بروید (معمولاً public_html یا htdocs). در این پوشه، فایلی متنی با نام “robots.txt” به صورت دستی ایجاد کنید.

- افزودن دستورات: دستورات robots.txt با خطوط خالی از یکدیگر جدا میشوند. هر دستور شامل دو بخش اصلی است: User-agent که مشخص میکند این دستور برای کدام خزنده موتور جستجو اعمال میشود و Directive که برای خزنده مربوطه باید اجرا شود.

- ذخیره فایل: پس از دستورات موردنظر خود را وارد کردید، فایل robots.txt را ذخیره کنید.

افزونه های سئو

بسیاری از افزونههای سئو محبوب مانند Yoast SEO و Rank Math ابزاری برای ایجاد و مدیریت فایل robots.txt به طور خودکار ارائه میدهند و در واقع شما نیازی نیست اقدام خاصی انجام دهید.

ابزارهای آنلاین

ابزارهای آنلاین مختلفی مانند ryte.com وجود دارند که به شما کمک میکنند تا فایل robots خود را به طور خودکار ایجاد کنید.

ویرایش فایل robots txt چگونه انجام می شود؟

- قبل از این که اقدام به ویرایش فایل robots.txt کنید بهتر است یک نسخه پشتیبان تهیه کنید. این کار در صورت بروز هرگونه مشکلی به شما امکان بازگشت به نسخه قبلی را می دهد.

- در مرحله بعدی باید به فایل robots سایت خود دسترسی پیدا کنید. اکثر هاست ها این فایل را در پوشه اصلی وب سایت شما قرار می دهند. می توانید با استفاده از FTP یا File Manager هاست خود به این فایل دسترسی پیدا کنید.

- حال با استفاده از یک ویرایشگر متن ساده، می توانید دستورات robots.txt را مطابق با نیاز خود ویرایش کنید.

- پس از انجام ویرایش فایل robots.txt آن را ذخیره کرده و سپس در پوشه اصلی وب سایت خود آپلود کنید.

مهم ترین دستورات فایل robots.txt همراه با مثال

درون این فایل دستورات مختلفی با فرمت خاص وجود دارد که هر کدام وظیفهای را برای راهنمایی موتورهای جستجو ایفا میکنند. در ادامه به بررسی مهمترین دستورات فایل robots.txt میپردازیم. با ما همراه باشید.

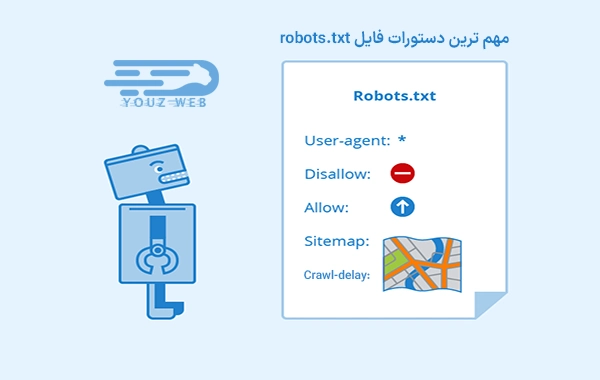

1) User-agent

این دستور مشخص میکند که کدام رباتها میتوانند دستورات فایل robots.txt را دنبال کنند. به طور پیش فرض، دستورات برای تمام رباتها اعمال میشود.

مثال:

User-agent: *

در این مثال، تمام رباتها میتوانند دستورات این فایل را دنبال کنند.

2) Disallow

این دستور به رباتها میگوید که به کدام مسیرها یا صفحات وبسایت شما نباید دسترسی داشته باشند.

مثال :

Disallow: /wp-admin/

Disallow: /cgi-bin/

در این مثال، رباتها به دایرکتوریهای wp-admin و cgi-bin که معمولاً حاوی اطلاعات حساسی هستند، دسترسی نخواهند داشت.

3) Allow

این دستور به رباتها میگوید که میتوانند به صفحاتی که با دستور Disallow مسدود شدهاند، دسترسی داشته باشند.

مثال:

Disallow: /images/

Allow: /images/products/

در این مثال، رباتها به تمام تصاویر موجود در پوشه images به جز تصاویر موجود در پوشه products دسترسی نخواهند داشت.

4) Sitemap

این دستور به موتورهای جستجو مکان فایل نقشه سایت (sitemap) شما را معرفی می کند. نقشه سایت فایلی است که لیستی از تمام صفحات وبسایت را به موتورهای جستجو ارائه میدهد تا بتوانند به طور کارآمدتر آنها را خزیده و ایندکس کنند.

مثال:

Sitemap: https://www.example.com/sitemap.xml

در این مثال، موتورهای جستجو میتوانند نقشه سایت وبسایت شما را در آدرس https://www.example.com/sitemap.xml پیدا کنند.

5) Crawl-delay

این دستور به رباتها میگوید که بین خزیدن هر صفحه چقدر صبر کنند. این دستور برای جلوگیری از بارگذاری بیش از حد سرور شما توسط رباتها مفید است.

مثال:

Crawl-delay: 10

در این مثال، رباتها بین خزیدن هر صفحه 10 ثانیه صبر میکنند.

نکات مهم:

- دستورات robots.txt به استفاده از حروف بزرگ و کوچک حساس هستند.

- دستورات این فایل به صورت سطر به سطر خوانده میشوند. اولین دستور Disallow برای یک مسیر، دسترسی به تمام زیرشاخههای آن مسیر را نیز مسدود میکند.

- پس از انجام هر گونه تغییر در فایل robots.txt، می توانید از ابزار تست robots.txt گوگل برای بررسی صحت دستورات فایل خود استفاده کنید.

بیشتر بخوانید

روشهای بهینه سازی فایل robots

بهینه سازی فایل robots نقش مهمی در سئو و عملکرد کلی وبسایت شما ایفا میکند. در ادامه به بررسی روشهای مختلف بهینهسازی فایل robots.txt میپردازیم:

- همیشه User-agent خزندههای اصلی موتورهای جستجو مانند Googlebot، Bingbot و YahooSlurp را مجاز کنید.

- در صورت استفاده از ابزارهای تحلیلگر وب مانند Google Analytics یا Search Console، User-agent آنها را نیز مجاز کنید.

- به طور کلی، از مسدود کردن صفحات اصلی، تصاویر، CSS و JavaScript خودداری کنید. این موارد برای سئوی سایت شما ضروری هستند.

- اگر به دلایلی مجبور به مسدود کردن برخی صفحات هستید، از روشهای جایگزین مانند robots.txt متا یا noindex در تگهای HTML استفاده کنید.

- پوشههایی مانند /tmp/، /cgi-bin/ و /admin/ را که حاوی محتوای عمومی یا تکراری هستند، مسدود کنید. این کار به خزندهها کمک میکند تا روی صفحات مهمتر سایت شما تمرکز کنند و از crawl شدن صفحات غیرضروری که میتواند سرعت ایندکس شدن را کاهش دهد، جلوگیری میکند.

- ابزارهای متعددی مانند Screaming Frog و Sitebulb به شما کمک میکنند تا فایل robots خود را بررسی و خطاهای احتمالی را شناسایی کنید. از این ابزارها برای تجزیه و تحلیل ساختار سایت و اطمینان از اینکه خزندهها به درستی به تمام صفحات مهم دسترسی دارند، استفاده کنید.

- با ایجاد تغییرات در وبسایت خود، مانند اضافه کردن صفحات جدید یا حذف صفحات قدیمی، فایل robots خود را به روز نگه دارید. این کار به خزندهها کمک میکند تا همیشه اطلاعات دقیقی از ساختار سایت شما داشته باشند و از ایندکس شدن صفحات نامعتبر جلوگیری میکند.

- از robots.txt برای جایگزینی سایر روشهای سئو مانند noindex یا canonicalization استفاده نکنید.

- باید بدانید که robots.txt فقط برای خزندهها قابل مشاهده است و تاثیری بر کاربران نهایی ندارد.

- به خاطر داشته باشید که robots.txt یک ابزار قدرتمند است و استفاده نادرست از آن میتواند به سئوی سایت شما آسیب برساند. همیشه یک نسخه پشتیبان از فایل robots.txt خود تهیه کنید تا در صورت بروز خطا بتوانید به راحتی آن را بازیابی کنید.

جمع بندی

در این مقاله از وبلاگ سئویوز وب، به معرفی و بررسی یکی از مهم ترین فایل های یک وب سایت که تاثیر بسیار زیادی در سئو آن دارد پرداختیم. امیدواریم حالا به طور کامل بدانید فایل robots.txt چیست و با انواع دستورات آن آشنا شده باشید. درک دقیق از نوع دستوراتی که در این فایل استفاده می گردد و انتخاب این دستورات بر اساس نیازها و استراتژی سئو سایت شما، میتواند منجر به بهبود عملکرد وب سایت شده و موفقیت شما را در دنیای دیجیتال تضمین نماید. همچنین می توانید تجربه بهتری برای خود و کاربران تان رقم زده و به اهداف خود در فضای آنلاین نزدیکتر شوید.

خوشحال خواهیم شد سوالات و نظرات خود را در بخش دیدگاه ها با مطرح نمایید. اگر نیاز به کمک دارید از همین بخش درخواست خود را ثبت کنید تا در اسرع وقت شما را راهنمایی کنیم.

سوالات متداول

فایل robots.txt چیست؟

فایل robots.txt فایلی متنی است که در ریشه وب سایت شما قرار می گیرد و به موتورهای جستجو مانند گوگل، بینگ و یاهو دستور می دهد که کدام صفحات وب سایت شما را می توانند خزش و فهرست بندی کنند و کدام صفحات را باید نادیده بگیرند.

چرا استفاده از فایل robots.txt مهم است؟

از فایل robots.txt برای جلوگیری از خزش و ایندکس بخش هایی از وب سایت شما که نمی خواهید در نتایج جستجو ظاهر شوند استفاده می شود. این کار می تواند به دلایل مختلفی مانند محافظت از صفحات خصوصی، جلوگیری از ایندکس محتوای تکراری یا جلوگیری از خزش بیش از حد وب سایت شما توسط موتورهای جستجو انجام شود.

آیا حتما باید از فایل robots.txt استفاده کنم؟

خیر، استفاده از فایل robots.txt اجباری نیست. با این حال، اگر می خواهید کنترل بیشتری بر نحوه ایندکس وب سایت خود توسط موتورهای جستجو داشته باشید، استفاده از آن را توصیه می کنیم.

چگونه می توانم مطمئن شوم که فایل robots.txt من به درستی کار می کند؟

می توانید از ابزار robots.txt Tester گوگل برای بررسی صحت فایل robots.txt خود استفاده کنید. این ابزار به شما نشان می دهد که کدام صفحات وب سایت شما توسط موتورهای جستجو قابل خزش و ایندکس هستند.

اگر از فایل robots.txt استفاده نکنم چه اتفاقی می افتد؟

اگر از فایل robots.txt استفاده نکنید، موتورهای جستجو تمام صفحات وب سایت شما را که می توانند به آنها دسترسی داشته باشند، خزش و ایندکس می کنند. این موضوع می تواند منجر به ایندکس تمام صفحات خصوصی، محتوای تکراری یا صفحات با کیفیت پایین شود که در نهایت به رتبه بندی وب سایت شما در نتایج جستجو آسیب خواهد رساند.

آیا باید فایل robots.txt خود را به روز رسانی کنم؟

بله، شما باید فایل robots.txt خود را به طور مرتب به روز رسانی کنید، به خصوص اگر وب سایت خود را تغییر دهید یا صفحات جدیدی اضافه کنید.